У фільмі 1997 року «Виконавець бажань» (Wishmaster) персонажі страждали від виконання неакуратно сформульованих бажань: виконував їх джин, був формально точний, але не брав до уваги справжніх приорітетів замовників. Можливо, такимиі будуть і штучні інтелектуальні системи, які намагатимуться виконувати висловлені нами бажання?

Небезпека застосування машин з штучним інтелектом, що виконують наші накази, полягає в тому, що бажання ми схильні висловлювати дуже недбало. Рядки коду, які будуть «оживляти» ці машини, неминуче забудуть врахувати нюанси і не сформулюють на цей рахунок виразного застереження, в результаті чого системи штучного інтелекту отримають завдання (чи навіть накази), які не були погоджені з нашими істинними уподобаннями.

Класичний уявний експеримент, який ілюструє цю проблему, провів в 2003 році оксфордський філософ Нік Бострем (Nick Bostrom). Описаний їм суперінтеллектуальний робот, запрограмований виготовляти канцелярські скріпки, тобто виконувати, здавалося б, нешкідливу роботу, з часом починає перетворювати весь світ в гігантську фабрику з виробництва скріпок.

Такий сценарій нерідко оцінювали як такий, що представляє небезпеку, яка може виникнути тільки в далекому майбутньому. Але штучний інтелект став проблемою набагато раніше, ніж очікувалося.

Візьмемо найбільш тривожний приклад — той, який негативно вплинув на мільярди людей. Відеохостинг YouTube, прагнучи максимізувати час переглядів, використовує створювані на базі штучного інтелекту алгоритми рекомендації контенту. Два роки тому вчені-комп’ютерники і користувачі почали помічати, що алгоритм YouTube, схоже, прагне виконувати поставлене перед ним завдання, рекомендуючи все більш екстремальний і конспірологічний контент. Одна дослідниця повідомила, що після того, як вона переглянула відеоматеріали про мітинги, що проходили в рамках виборчої кампанії Дональда Трампа, YouTube запропонував їй відео з «демагогічними промовами білих расистів, заявами про те, що ніякого Голокосту не було та іншим неадекватним контентом. Входячи в «розумінні потреб користувача», алгоритм виходить за рамки політики здорового глузду. «Відео про вегетаріанство, — зазначила дослідниця, — привело мене до відео про веганство. Відео про легкий біг заради гімнастики — до відео про біг на надмарафонській дистанції». В результаті, як показують дослідження, алгоритм YouTube просто для того, щоб ми продовжували перегляди, сприяє поляризації і радикалізації суспільних поглядів і поширює дезінформацію.

«Якби я планував застосування цієї технології в масовому масштабі, я б, мабуть, постарався уникнути такого ефекту при її апробації», — каже Ділан Хедфілд-Менелла (Dylan Hadfield-Menell), дослідник штучного інтелекту з Каліфорнійського університету в Берклі (University of California , Berkeley).

У програмістів YouTube, ймовірно, не було мети радикалізувати людство. Але кодери не можуть думати про все на світі. «Нинішній спосіб створення такого явища як штучний інтелект покладає на розробників занадто велике навантаження, змушуючи їх передбачити, якими будуть наслідки цілей, які вони вводять в свої системи, — зазначає Хедфілд-Менелла. — І помилки, допущені багатьма розробниками, — це те, з чого необхідно винести уроки».

Головний аспект проблеми полягає в тому, що люди часто не знають, на що націлювати системи штучного інтелекту, тому що не знають, чого насправді хочуть.

«Запитайте кого-небудь на вулиці:

«Чого ви хочете від свого безпілотного автомобіля?»- і вам дадуть відповідь так: » Запобігання ДТП», — говорить Дорсі Садіх (Dorsa Sadigh), фахівець із Стенфордського університету (Stanford University), що досліджує штучний інтелект і спеціалізується на взаємодії людини і робота. — Але ясно ж, що цього звмало; людям хочеться ще багато чого».

Супербезпечні безпілотні автомобілі їздять занадто повільно і гальмують так часто, що пасажирам стає погано. Коли програмісти намагаються перерахувати всі цілі і переваги, які має одночасно враховувати робомобіль, список неминуче виявляється неповним. За словами Садіх, коли вона, керуючи автомобілем, їхала по Сан-Франциско, її часто змушували гальмувати безпілотні машини, які зупинялися на дорозі. Вони, як і вимагає їх програма, ретельно уникають контакту з рухомими об’єктами, але такими об’єктами можуть бути і пластикові пакети, що переміщу разом із вітром.

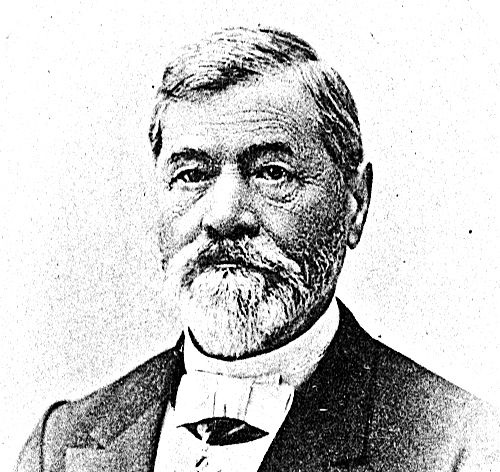

Щоб уникнути такого роду пасток і створити теоретичну базу для вирішення проблеми усунення відхилень такого явища як штучний інтелект, дослідники приступили до розробки абсолютно нового методу програмування машин-помічників. На формування цього підходу найбільшою мірою вплинули ідеї і дослідження Стюарта Рассела, 57-річного вченого-комп’ютерника з Берклі, який має нагороди за наукову діяльність. У 80-х і 90-х роках ХХ століття Рассел прославився новаторськими дослідженнями, присвяченими раціональності прийняття рішень і машинного навчання. Він — головний автор популярного підручника «Штучний інтелект: сучасний підхід» (Artificial Intelligence: A Modern Approach). За останні п’ять років його голос став особливо впливовим в тому, що стосується проблеми усунення відхилень. Цей стриманий британець в чорному костюмі, що вміє внятно і по суті говорити, — постійний учасник міжнародних зустрічей і дискусійних форумів, де обговорюється штучний інтелект — висвітлює пов’язані з ним ризики і довгострокове управління.

На думку Рассела, сьогоднішня культура функціонування штучного інтелекту, який переслідує ту чи іншу мету, є, за великим рахунком, обмеженою, незважаючи на всі успіхи у виконанні конкретних завдань — таких, як перемога над людиною в Jeopardy! і шахах, розпізнавання предметів на зображеннях і слів у мові і навіть створення музичних і літературних творів. Рассел стверджує, що вимога від машини оптимізувати «функцію винагороди» — ретельний опис деякої комбінації цілей — неминуче веде до відхилення штучного інтелекту, оскільки функцію не можна врахувати і правильно зважити всі цілі, підцілі, винятки та застереження або навіть визначити, які з них правильні. По мірі того, як самостійні, «автономні» роботи будуть ставати все більш розумними, задавати їм цілі буде все більш небезпечно, бо роботи, здійснюючи свою функцію винагороди, будуть невблаганні і при цьому намагатимуться завадити нам їх відключити.

Згідно з новим підходом, замість того, щоб переслідувати свої власні цілі, машина повинна прагнути задовольняти переваги людини; її єдина мета повинна полягати в тому, щоб дізнатися якомога більше про ці переваги. Рассел стверджує, що системи ШІ завдяки невпевненості в наших перевагах і необхідності звертатися до нас за вказівками, не завжди залишатимуться безпечними для людини. У недавній книзі «Сумісний з людиною» (Human Compatible) Рассел викладає свою тезу в формі трьох «принципів корисних машин», які повторюють три закони робототехніки Айзека Азімова (Isaac Asimov), сформульованим в 1942 році, але не так наївно. Версія Рассела така:

- Єдина мета машини — максимально реалізувати людські бажання.

- Машина спочатку не впевнена в тому, що їй відомі ці бажання.

- Кінцеве джерело інформації про бажання людини — це поведінка людини.

Всі останні роки Рассел і його команда в Берклі, а також групи однодумців в Стенфорді, Техаському університеті (University of Texas) та інших місцях розробляють інноваційні способи дати системам ШІ ключ до впізнавання наших бажань, навіть якщо останні явно не описані.

Зазначені команди дослідників вчать роботів з’ясовувати бажання людини, яка не формулює їх і, можливо, навіть не впевнена в тому, чого хоче. Ці роботи знаходять здатність впізнавати наші бажання, спостерігаючи за їх невиразною демонстрацією, навіть винаходити нові способи поведінки, що допомагають усувати двозначність людських бажань. (Наприклад, зустрічаючи чотиристоронній знак «стоп», безпілотні автомобілі виробили звичку трохи відступати, пропонуючи рухатися вперед водіям-людям). Досягнуті результати свідчать про те, що штучний інтелект може точно визначати наші настрої та уподобання навіть тоді, коли доводиться з’ясовувати їх на льоту.

«Це всього лише перші спроби формалізувати проблему, — підкреслює Садіх. — Люди зовсім недавно усвідомили, що культура взаємодії людини і робота вимагає більшої уваги».

Чи справді нинішні стартові зусилля і три зазначені вище принципи корисних машин Рассела віщують ШІ світле майбутнє, поки неясно. Цей підхід пов’язує успішний розвиток робототехніки з її здатністю розуміти, що реально, насправді воліють люди, і вже кілька років роботи роблять спроби вирішити це завдання. На думку дослідника усунення відхилень Пола Крістіано (Paul Christiano) з OpenAI, Рассел і його команда, як мінімум, значно прояснили проблему і допомогли «визначити контури бажаноЇ поведінки — того, до чого ми прагнемо».

Як зрозуміти людину

Основна теза Рассела прийшла до нього як осяяння, як піднесений акт розуму. Це було в 2014 році, під час творчої відпустки, коли вчений з Берклі, перебуваючи в Парижі, прямував на репетицію хору, куди записався як тенор. «Оскільки у мене не дуже хороший музичний слух, — згадував він недавно, — я завжди старанно розучував музику, добираючись на репетицію на метро». Хорове аранжування «Agnus Dei» Семюеля Барбера (Samuel Barber) 1967 року наповнило його навушники, коли він мчав у потязі.

«Це була така прекрасна музика! — повідав Рассел. — І тут мене осінило: те, що має значення, і, отже, те, що повинно бути метою ШІ, — це в певному сенсі сукупний тембр людського досвіду».

Роботи, усвідомив учений, не повинні переслідувати такі цілі, як максимізація часу переглядів або кількості скріпок; їм просто-напросто слід прагнути покращувати наше життя. Залишилося лише одне питання: «Якщо обов’язок машин — намагатися оптимізувати сукупний тембр людського досвіду, як же їм з’ясувати, що він собою являє?»

Новий підхід Рассела йде корінням в набагато більш далеке минуле, ніж 2014 рік. У 70-х роках ХХ століття, ще будучи лондонським школярем, він вивчав штучний інтелект, програмуючи хрестики-нулики і шахові партії на комп’ютері сусіднього коледжу. Пізніше, після переїзду в область затоки Сан-Франциско, сприятливу для дослідження ШІ, він почав міркувати про раціональне прийняття рішень. Незабаром учений прийшов до висновку, що таке прийняття рішень є неможливим. Люди навіть віддалено не раціональні, тому що в обчислювальному плані це нездійсненно: ми не можемо підрахувати, яка дія в будь-який даний момент часу призведе до найкращого результату в нашому далекому майбутньому; і штучний інтелект не може. Рассел припустив, що наш процес прийняття рішень є ієрархічним — ми досягаємо досить недосконалої раціональності, переслідуючи смутні довгострокові цілі за допомогою середньострокових, приділяючи при цьому найбільшої уваги обставинам. Роботизованим агентам, вирішив він, слід робити щось подібне або, принаймні, розуміти наші принципи роботи.

Паризьке прозріння Рассела відбулося в поворотний для досліджень в області культури штучного інтелекту час. Кількома місяцями раніше штучна нейронна мережа, що використала широко відомий підхід під назвою «навчання з підкріпленням», шокувала вчених тим, що швидко навчилася з нуля грати і перемагати в відеоіграх Atari. Попутно вона навіть придумувала нові прийоми. При навчанні з підкріпленням штучний інтелект навчається оптимізувати свою функцію винагороди, наприклад свій рахунок в грі; коли він пробує різні варіанти поведінки, ті з них, які збільшують функцію винагороди, закріплюються і ймовірність їх використання в майбутньому зростає.

Ще в 1998 році Рассел розробив протилежний підхід, а після працював над його покращенням разом зі своїм співробітником Ендрю Ином (Andrew Ng). Система, що використовує «підхід, протилежний навчанню з підкріпленням», не прагне оптимізувати закодовану функцію винагороди, як при навчанні з підкріпленням; замість цього вона прагне зрозуміти, яку функцію винагороди оптимізує людина. У той час як при навчанні з підкріпленням система визначає дії що ведуть до мети, при протилежному підході вона, коли їй надається певний набір дій, з’ясовує основну мету.

Через кілька місяців після свого прозріння, натхненного «Agnus Dei», на нараді з питань управління за допомогою штучного інтелекту в міністерстві закордонних справ Німеччини Рассел поговорив про підхід, протилежному навчанню з підкріпленням, з Ніком Бострома, який отримав популярність завдяки прикладу зі скріпками. «Саме там дві сторони питання з’єдналися», — заявив Рассел. У метро він зрозумів, що машини повинні прагнути оптимізувати сукупний тембр людського досвіду. А тепер він зрозумів, що, якщо їм неясно, як це зробити, — якщо комп’ютери не знають, що вважають за краще люди, — «вони, щоб дізнатися більше, можуть скористатися підходом, протилежним навчанню з підкріпленням».

При стандартному застосуванні даного підходу машина прагне з’ясувати функцію винагороди, яку переслідує людина. Але в реальному житті ми повинні бути готові активно допомагати їй вивчати нас. Повернувшись в Берклі після творчої відпустки, Рассел почав працювати зі своїми співробітниками над створенням нової, «кооперативної» версії підходу, протилежної навчанню з підкріпленням. При кооперативному підході робот і людина можуть взаємодіяти, з’ясовуючи справжні переваги людини в ході різних «допоміжних ігор». Абстрактні сценарії цих ігор відображають реальні ситуації, що вимагають діяти в умовах дефіциту знань.

Серед розроблених дослідниками ігор є та, що відома як «гра з вимикачем» (off-switch game). Вона присвячена одному з найбільш очевидних способів, за допомогою яких автономний робот може відхилитися в сторону від наших справжніх переваг: шляхом виведення з ладу свого вимикача. Алан Тьюринг в 1951 році (через рік після того, як опублікував новаторську статтю про штучний інтелект) під час лекціі на BBC припустив, що можна «утримувати машини в підпорядкуванні, наприклад, відключаючи в стратегічні моменти їх живлення». Нині таке рішення проблеми вважається занадто простим. Що заважає штучному інтелекту вивести з ладу власний вимикач або, в більш загальному сенсі, ігнорувати команди, що вимагають припинити максимізацію функції винагороди? Проблема виключення, написав Рассел в «Human Compatible», є «ядром проблеми управління інтелектуальними системами». Якщо ми не можемо вимкнути машину, оскільки вона противиться цьому, у нас серйозні проблеми. Якщо ми можемо, тоді ми зуміємо контролювати її і іншими способами».

Ключем до вирішення даної проблеми може виявитися невизначеність щодо наших переваг. Це продемонструвала формальна модель проблеми — гра з вимикачем, учасники якої людина на ім’я Гаррієт (Harriet) і робот на ім’я Роббі (Robbie). Роббі вирішує, діяти йому від імені Гаррієт — скажімо, забронювати їй хороший, але дорогий номер в готелі, — однак не знає, які її переваги. За підрахунками Роббі, його виграш (схвалення з боку Гаррієт) перебуває в діапазоні від -40 до +60, тобто в середньому становить +10 (Роббі думає, що Гаррієт, мабуть, сподобається вишуканий номер, але він не впевнений в цьому) . Якщо нічого не робити, то виграш дорівнює 0. Але є і третій варіант: Роббі може запитати Гаррієт, чи хоче вона, щоб він продовжував діяти або вважає за краще «вимкнути» його, тобто усунути від вирішення питання про бронювання номера. Якщо вона дозволить роботу продовжувати, середній очікуваний виграш стане більше +10. Тому Роббі вирішить проконсультуватися з Гаррієт і, якщо вона того забажає, дозволить їй вимкнути його.

Рассел і його співробітники довели, що, загалом, результат буде таким: Роббі віддасть перевагу надати Гаррієт самій прийняти рішення, якщо не буде точно знати, як в подібних випадках надходить сама Гаррієт. «Виявляється, — підкреслює Рассел в« Human Compatible », — що невизначеність щодо мети необхідна для забезпечення того, щоб ми могли вимкнути машину, — навіть тоді, коли машина розумніша за нас».

Як ми сприймаємо зміни в своєму настрої?

«Як ми сприймаємо зміни в своєму настрої? Щоб зрозуміти це, бідному роботу доведеться задуматися».

Ці та інші сценарії з дефіцитом знань були розроблені як абстрактні ігри, але в лабораторії Скотта Найкума в Техаському університеті в Остіні алгоритми з’ясування переваг перевіряють на реальних роботах. Спостерігаючи під час демонстрації сервірування столу за тим, як людина кладе виделку ліворуч від тарілки, Джеміні, дворукий робот з лабораторії, спочатку не може збагнути, чи завжди виделки повинні бути зліва від тарілок і чи завжди кожна виделка повинна виявитися на якомусь чітко визначеному місці. Йому не знайомі вподобання людини, її культурний код.

Нові алгоритми дозволяють роботові освоїти даний патерн без великого числа демонстрацій. Головне завдання Найкума — змусити системи ШІ кількісно визначати свою невизначеність щодо культурних вподобань людини, щоб вони мали можливість оцінювати, чи достатньо наявних у них знань для безпечних дій. «Ми, — зазначає дослідник, — прямо, без жодних натяків, розмірковуємо про той розподіл цілий в голові людини, який може виявитися правильним, а також про ризики, пов’язані з цим розподілом».

Нещодавно Найкум і його співробітники знайшли ефективний алгоритм, що дозволяє роботам розуміти пріоритети людини, її культурного коду. Що можна вимагати від робомобіля в обчислювальному плані? Всього лише навчитися маневрувати так, як показали йому водії-люди. Однак Найкум і його колеги виявили, що за допомогою демонстрацій, ранжируваних відповідно до того, наскільки добре людина-демонстратор впоралася із завданням, можна поліпшити і значно прискорити навчання робота. «Агент-робот, — каже Найкум, — ознайомившись з даними рейтингу, може подумати так: «Якщо це рейтинг, то що він пояснює? ««Що відбувається частіше і що рідше з поліпшенням демонстрацій?»» Остання версія цього алгоритму навчання, названого T-REX (від виразу «trajectory-ranked reward extrapolation» — «екстраполяція винагороди, ранжованої по траєкторії»), виявляє в ранжованих демонстраціях патерни, котрі розкривають можливі функції винагороди, реалізацію яких людьми можна оптимізувати. До того ж алгоритм вимірює відносну ймовірність різних функцій винагороди. Застосовуючи байесівский T-REX, робот, за словами Найкума, здатний ефективно визначити найбільш ймовірні правила сервірування столу або мету гри Atari «навіть в тому випадку, коли він не бачив ідеальної демонстрації».

Наш недосконалий вибір

Ідеї Рассела «опановують розумами спільноти дослідників штучного інтелекту», констатує Йошуа Бенжі (Yoshua Bengio), науковий керівник монреальського інституту Mila — одного з провідних в області дослідження ШІ. Вчений вважає, що підхід Рассела, при якому системи штучного інтелекту прагнуть зменшити власну невизначеність щодо переваг людини, можна реалізувати за допомогою глибокого навчання — потужного методу, що забезпечив нещодавні революційні досягнення в галузі ШІ завдяки тому, що в пошуках патернів система просіює дані через шари штучної нейромережі. «Для цієї реалізації, звичайно ж, потрібні додаткові дослідження», — зазначає він.

Рассел бачить дві основні проблеми. «По-перше, наша поведінка настільки далеко від раціональнї, що з’ясування наших справжніх основних переваг може представляти величезні труднощі», — говорить він. Системи штучного інтелекту повинні будуть міркувати про ієрархію довгострокових, середньострокових і короткострокових цілей — про міріади переваг і зобов’язань, якими ми обплутані. Щоб допомагати нам (і уникати грубих помилок), роботам доведеться розбиратися в туманних мережах наших підсвідомих вірувань і нечітких бажань.

По-друге, людські побажання змінюються. Наш розум еволюціонує протягом всього нашого життя, але, крім того, може змінюватися миттєво, в залежності від нашого настрою або обставин, що змінилися, і робот змушений буде все це враховувати, тобто якоюсь мірою стати психологом.

До того ж наші дії не завжди відповідають нашим ідеалам. Люди здатні одночасно ставити перед собою цілі, які часто суперечать одна одній. Реалізацію яких цілей слід оптимізувати роботу? Щоб не вийшло так, що він обслуговує найгірші з наших імпульсів (або, що ще гірше, підсилює ці імпульси, як вищезгаданий алгоритм YouTube, тим самим полегшуючи досягненню насправді непотрібних цілей), роботу слід з’ясувати те, що Рассел називає нашими метабажаннями, — «думки щодо прийнятності або неприйнятності тих чи інших процесів зміни уподобань». Як ми сприймаємо зміни в своєму настрої? Щоб зрозуміти це, бідному роботу доведеться попітніти.

Як і роботи, ми прагнемо з’ясувати наші приорітети (які вони зараз і якими ми хочемо бачити їх у майбутньому), а також шляхи усунення неясностей і протиріч. Подібно найкращому з можливих штучних інтелектів, ми прагнемо до того ж — принаймні, деякі з нас, в деякі моменти часу — зрозуміти «форму добра», як назвав предмет пізнання філософ Платон. Як і ми, системи штучного інтелекту можуть, намагаючись знайти відповідь на питання, зависнути назавжди — чи в вимкненому стані чекати результатів, якщо невпевненість позбавила можливості виступати в ролі помічника.

«Я не розраховую, — каже Крістіано, — що найближчим часом нам вдасться твердо визначити, що є добро, чи отримати ідеальні відповіді на будь-які емпіричні питання, з якими ми стикаємося. Однак я сподіваюся, що системи штучного інтелекту, які ми створюємо, зможуть відповідати на ці питання так само, як і люди, і зрештою зможуть досягати цілей, які дійсно для людей є приорітетними — щонайменше, іноді».

Але в короткий список, складений Расселом, варто включити ще одну, третю за рахунком, важливу проблему: як бути з уподобаннями поганих людей? Що утримає робота від реалізації мерзенних цілей його злого власника? Система штучного інтелекту норовить обходити заборони так само, як корупціонер знаходить лазівки у податковому законодавстві, тому просто забороняти їй чинити злочини, ймовірно, буде марно.

Можна згустити фарби: що, якщо всі ми в деякому роді погані? Той алгоритм рекомендацій, який з усіх сил намагається виправити в YouTube, побудований, як не крути, з урахуванням людських імпульсів, що зустрічаються повсякчас.

Проте, Рассел налаштований оптимістично. Хоча потрібні додаткові алгоритми і подальший розвиток теорії ігор, його інтуїція підказує йому, що розробникам вдасться впоратися з шкідливими уподобаннями і що той же самий підхід, який розроблений для роботів, здатний виявитися корисним навіть «при вихованні дітей, шкільному і вузівському навчанні і так далі». Іншими словами, ми могли б, навчаючи роботів добру, знайти спосіб навчити і самих себе. «Здається мені, — додає Рассел, — що ми на правильному шляху».

Автор: Наталі Волховер (Natalie Wolchover)

Переклад: Юрій Чабан

ЧИТАЙТЕ ТАКОЖ: Емоційний інтелект і акторська майстерність